案例 1:使用 MCP 实现 AI 播客生成器

本节内容,我们将通过一个实际的例子来讲解,如何组合使用 MCP 服务器,实现一个 AI 播客生成器。

在开始正式内容之前,先介绍一下 PodLM 这款产品:

PodLM 是我在 2024 年 10 月开发的一款产品,定位是“AI 播客生成器”,核心功能是根据用户输入的网址或话题,生成一段多人对话的音频,以播客的形式输出。PodLM 产品官网如图所示:

图:PodLM 产品官网

PodLM 受到了去年谷歌发布的产品:NotebookLM 的启发。NotebookLM 是一款专注于个人知识库问答的产品,因其支持把知识库内容转换成双人对谈播客的功能而出圈。

跟 NotebookLM 的定位不一样,PodLM 专注于播客内容的生成与音频输出。借助大模型的多模态能力,把网页或文字内容,转成富有情绪感染力的播客形式,让用户用“听”的方式,去了解自己感兴趣的内容。

PodLM 是一个 SaaS(软件即服务) 产品,生成播客的流程是通过代码实现的。在接下来的内容中,我们将通过组合使用 MCP 服务器,来实现 PodLM 生成播客的核心功能。

5.2.1 实现目标

PodLM 网页版的功能,支持通过输入话题、网页 URL、长文本三种方式作为生成播客内容的参考。

用户可以自定义输出的播客风格、语言,模型来生成播客脚本,选择 TTS(Text To Souds,文本转声音)将播客脚本转成音频。

PodLM 播客生成器页面如图所示:

图:PodLM 播客生成器页面

在未编码的情况下,使用 MCP 服务器来实现上述功能,完成度可能不及 PodLM。我们不打算完整复刻 PodLM 的功能,而是选择其中颇具代表性的一两个功能点,通过组装 MCP 服务器的方式来完成。

我们选择以下两个功能,来分析下实现的思路和步骤:

- 通过话题生成播客

用户输入想要在播客中讨论的内容或话题,选择播客风格,大模型生成播客脚本,应用把播客脚本内容转成音频输出。

播客脚本由大模型进行推理生成,我们需要准备一套提示词,让大模型输出符合指定风格的播客脚本。

文本转音频需要 TTS 模型的支持。知名的 TTS 服务商包括 ElevenLabs、OpenAI、MiniMax 等。

多人对谈播客需要通过编码合成多段音频,只靠组装 MCP 服务器不好实现,我们选择实现单人播客。

总结起来,要实现通过话题生成播客的需求,我们需要准备:

- 单人播客(比如:单人脱口秀)提示词模板

- 输出稳定性高的文本大模型(比如:deepseek-v3),用于生成播客脚本

- 把文本内容转换成音频的 MCP 服务器

- 可选:联网查询的 MCP 服务器,为输入的话题补充实时信息

- 通过网页 URL 生成播客

跟通过话题生成播客的需求类似,通过网页 URL 生成播客,我们需要准备:

- 单人播客(比如:实时评论)提示词模板

- 输出稳定性高的文本大模型(比如:deepseek-v3),用于生成播客脚本

- 获取网页 URL 内容的 MCP 服务器,为生成播客脚本提供上下文

- 把文本内容转换成音频的 MCP 服务器

需求分析清楚之后,接下来我们就着手来实现。

5.2.2 准备 MCP 服务器

在实现 AI 播客生成的需求之前,我们先准备需要用到的 MCP 服务器。根据需求分析,需要用到的 MCP 服务器提供的工具包括:

- 文本转音频

- 联网搜索

- 读取网页内容

在 MCP.so 平台通过关键词搜索,可以找到很多满足需求的 MCP 服务器,根据我们自身的需求和喜好,选择其中一个即可。

- 文本转音频

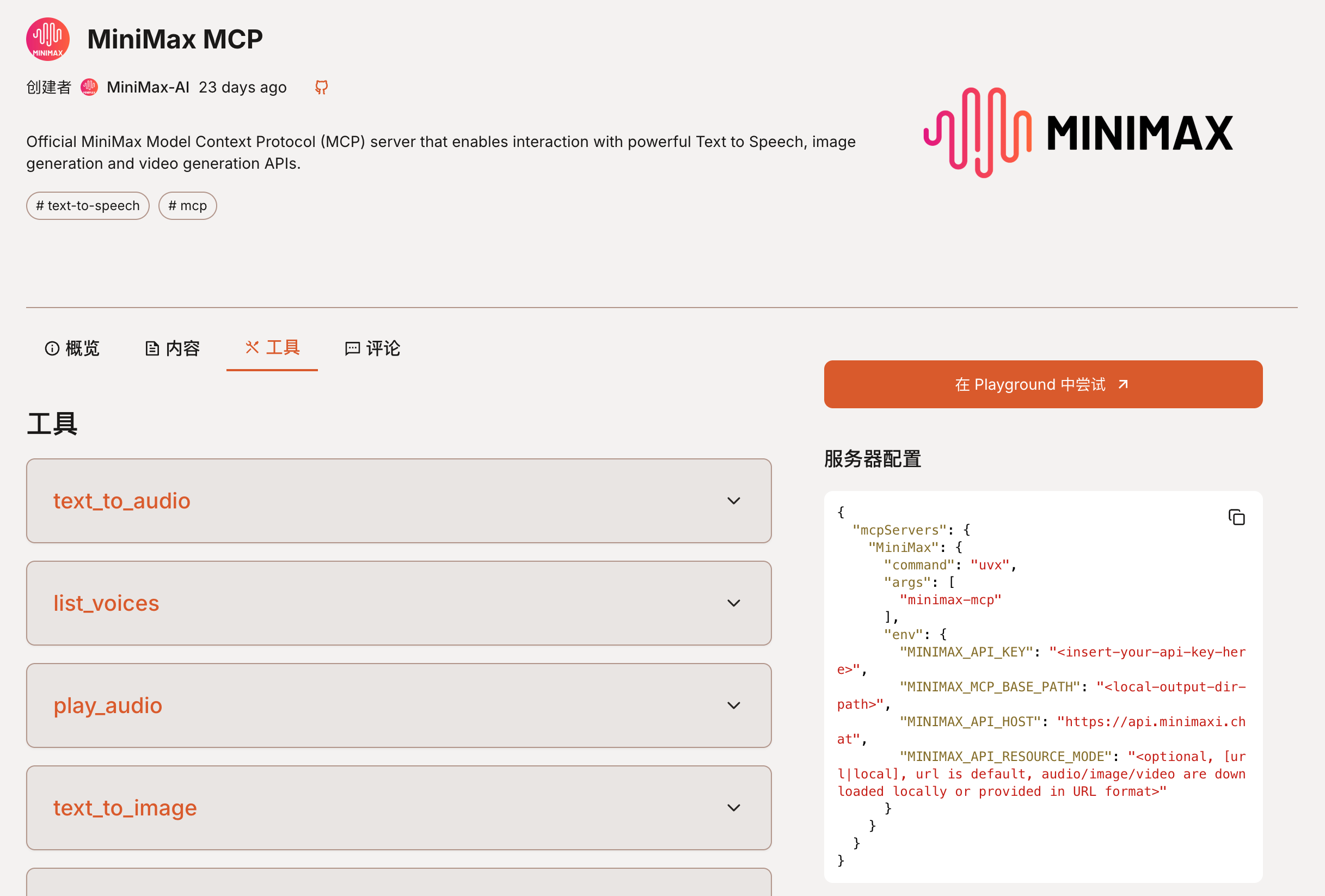

选择国产模型厂商 MiniMax 官方发布的 MCP 服务器,来实现文本转音频的需求。

图:MCP.so 平台上的 MiniMax MCP 服务器详情

参考文档说明,先完成此 MCP 服务器的配置:

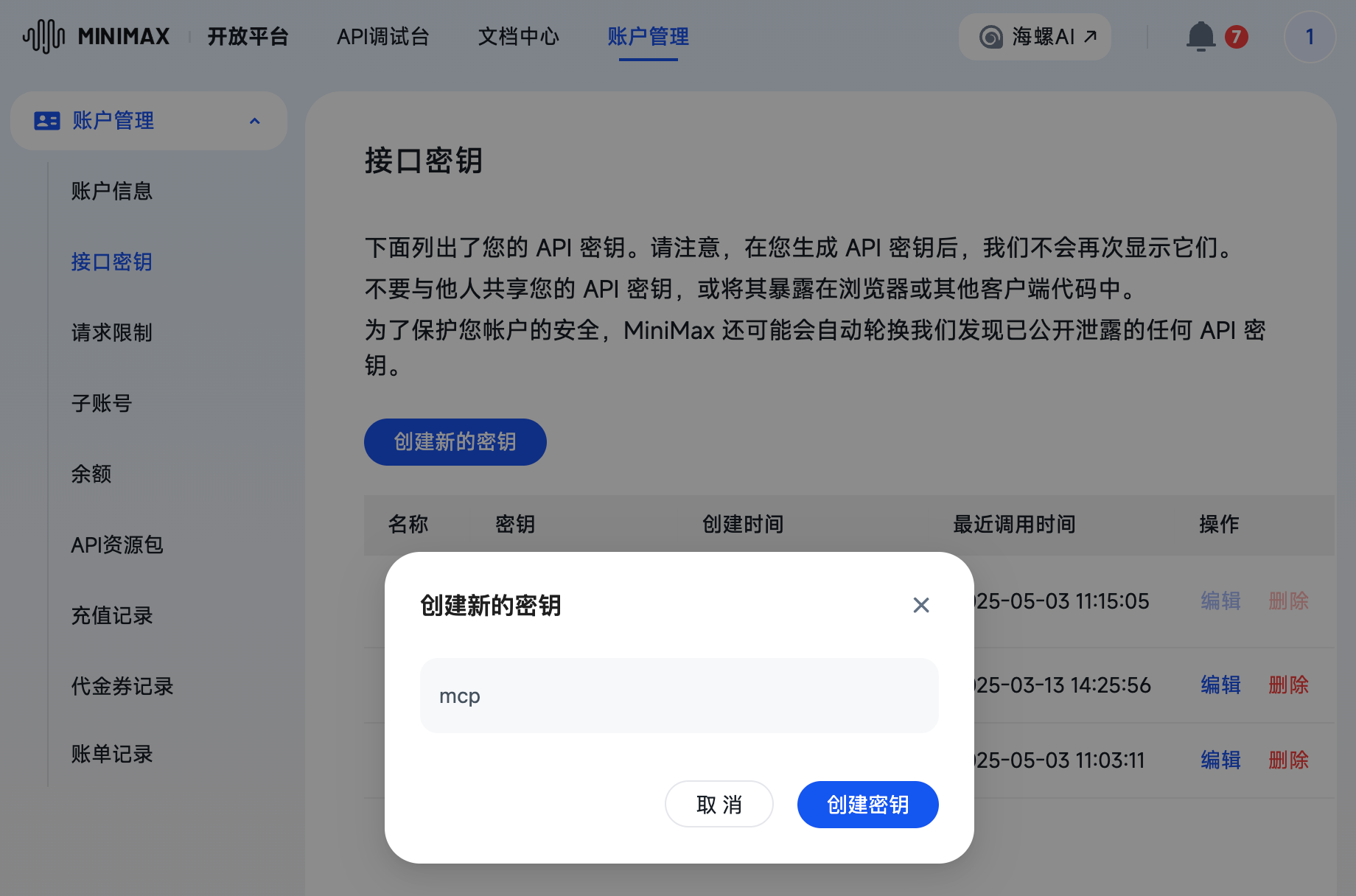

- 在 MiniMax 账户管理中心 创建接口密钥

图:在 MiniMax 账户管理后台创建接口密钥

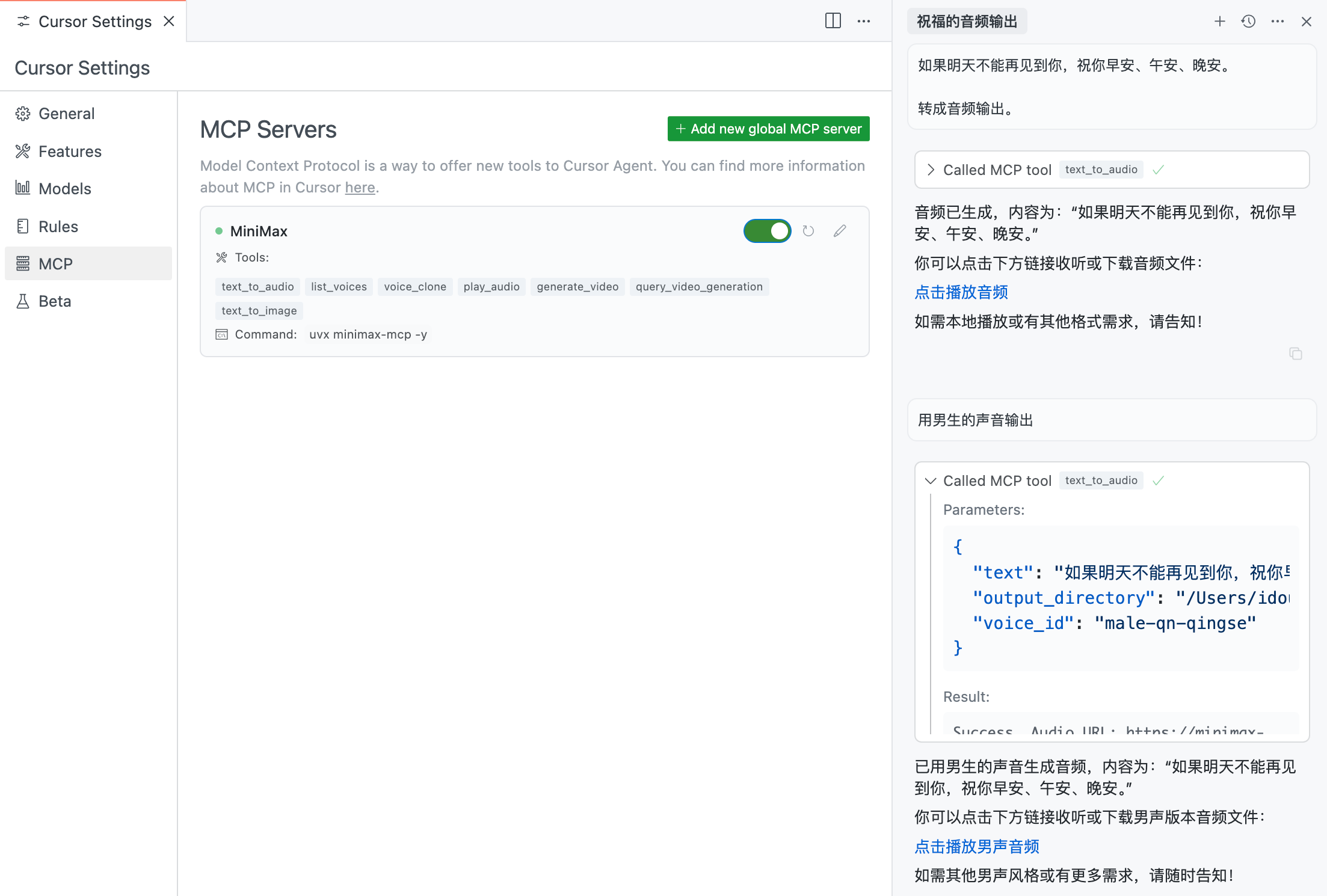

- 配置 MiniMax MCP 服务器

我们选择 Cursor 作为大模型客户端,在 Cursor 的 MCP 配置文件中,添加 MiniMax MCP 服务器的配置:

{ "mcpServers": { "MiniMax": { "command": "uvx", "args": ["minimax-mcp", "-y"], "env": { "MINIMAX_API_KEY": "xxx", "MINIMAX_MCP_BASE_PATH": "your-local-path", "MINIMAX_API_HOST": "https://api.minimax.chat", "MINIMAX_API_RESOURCE_MODE": "url" } } }}注意,这里的 MINIMAX_API_KEY 需要替换为在 MiniMax 账户管理后台创建的接口密钥。如果设置的 MINIMAX_API_RESOURCE_MODE 值是 url,MINIMAX_MCP_BASE_PATH 可以不填。

- 调试文本转音频

在 Cursor 中配置好 MiniMax MCP 服务器之后,可以看到此服务器提供的 Tools 列表。

其中的 text_to_audio 工具是我们本次需求需要用到的。

在 Cursor AI 对话面板,调试 MiniMax MCP 服务器的文本转音频功能,如图所示:

图:调试文本转音频

可以看到,此 MCP 服务器根据提供的文本,转成音频输出,也支持指定音色,满足播客音频输出的需求。

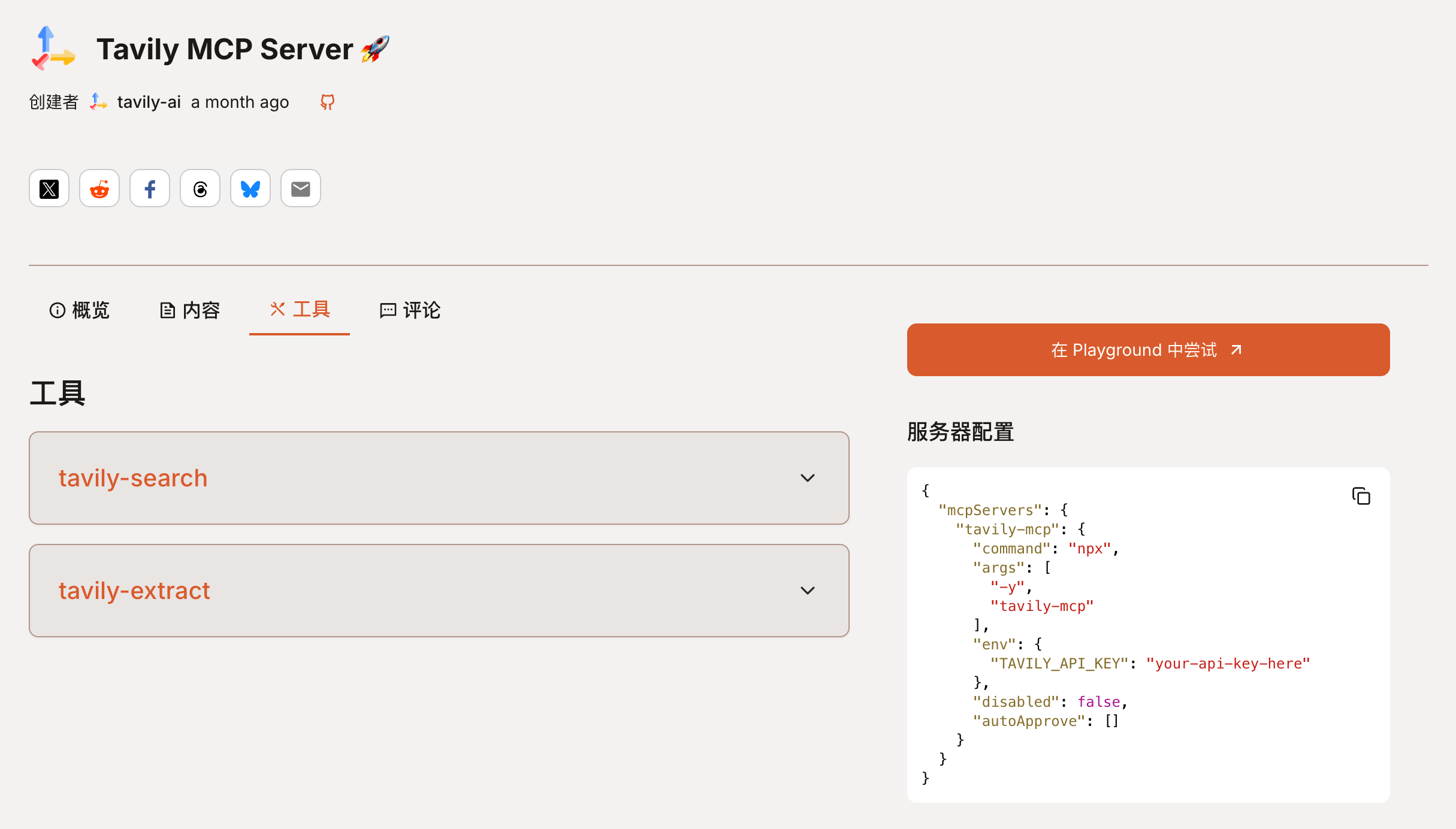

- 联网搜索

通过在 MCP 应用市场搜索,找到 Tavily MCP Server 这个 MCP 服务器,来实现联网搜索功能。此服务器在 MCP.so 平台上的详情如图所示:

图:MCP.so 平台上 Tavily MCP 服务器详情

参考文档说明,先完成此 MCP 服务器的配置:

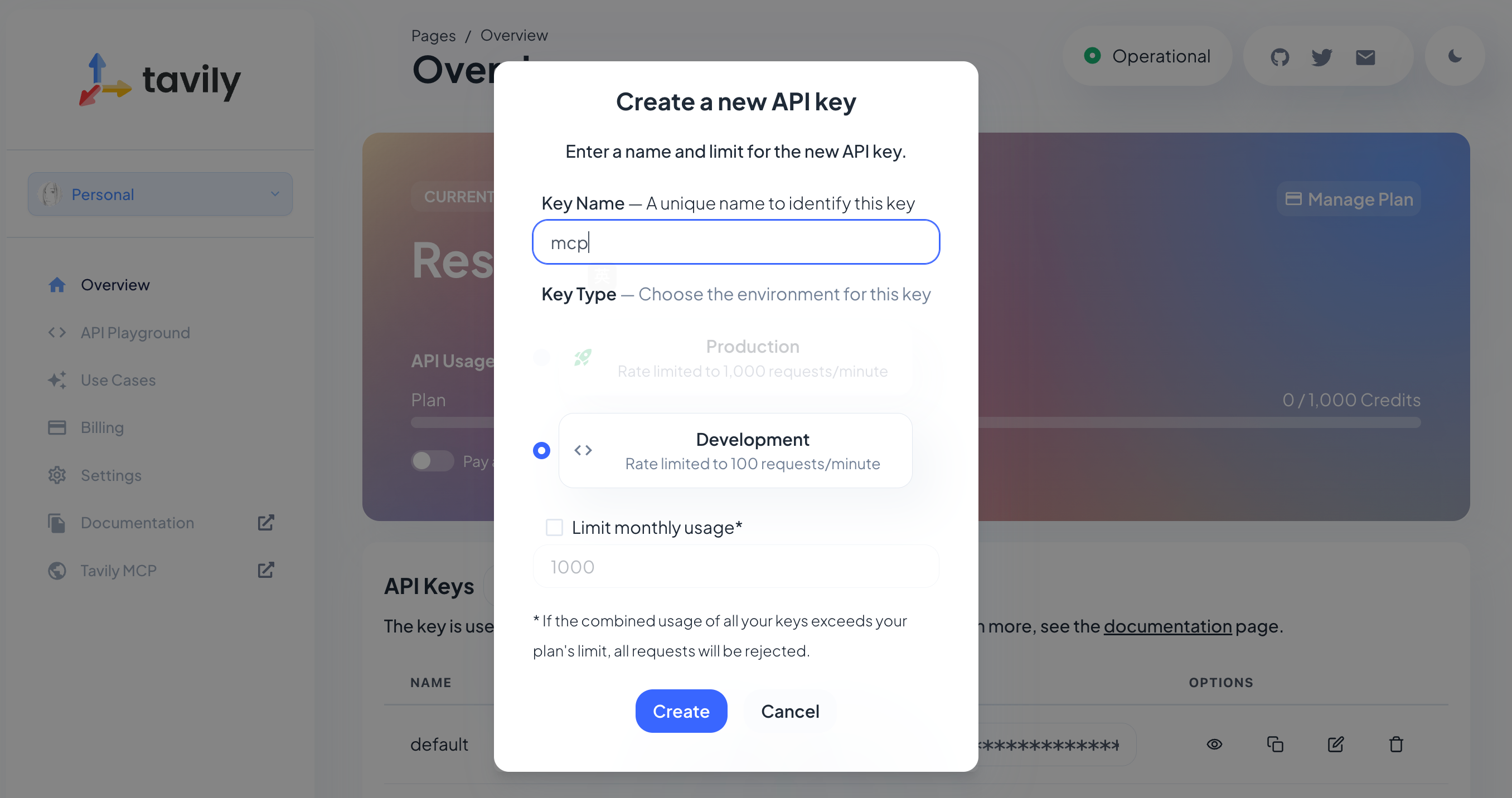

- 在 Tavily 管理后台 创建 ApiKey

图:在 Tavily 后台创建 ApiKey

- 配置 Tavily MCP 服务器

在 Cursor 的 MCP 配置文件中,添加 Tavily MCP 服务器的配置:

{ "mcpServers": { "tavily-mcp": { "command": "npx", "args": ["-y", "tavily-mcp"], "env": { "TAVILY_API_KEY": "xxx" }, "disabled": false, "autoApprove": [] } }}这里的 TAVILY_API_KEY 需要替换为在 Tavily 管理后台创建的 ApiKey。

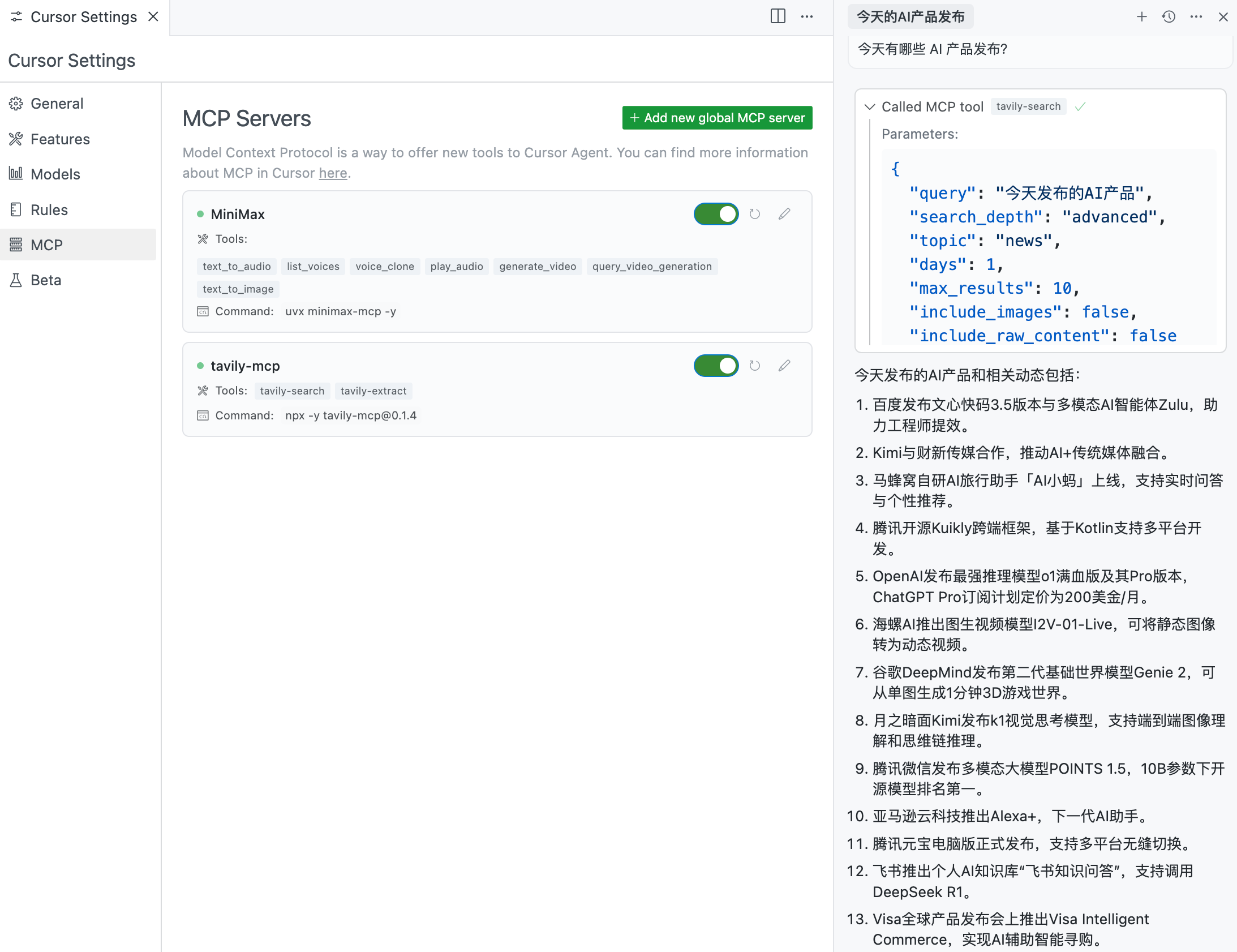

- 调试联网搜索

在 Cursor 中配置好 Tavily MCP 服务器之后,可以看到此服务器提供的 Tools 列表。

其中的 tavily-search 工具是我们本次需求需要用到的。

在 Cursor AI 对话面板,调试 Tavily MCP 服务器的联网搜索功能,如图所示:

图:调试 Tavily MCP 服务器联网搜索工具

可以看到,Tavily MCP 服务器能够查到互联网上的实时新闻,满足生成播客脚本时,联网搜索实时信息的需求。

- 获取网页 URL 内容

我们选择 Firecrawl MCP Server,来实现抓紧网页内容的需求。

图:MCP.so 平台上 Firecrawl MCP 服务器详情

参考文档说明,先完成此 MCP 服务器的配置:

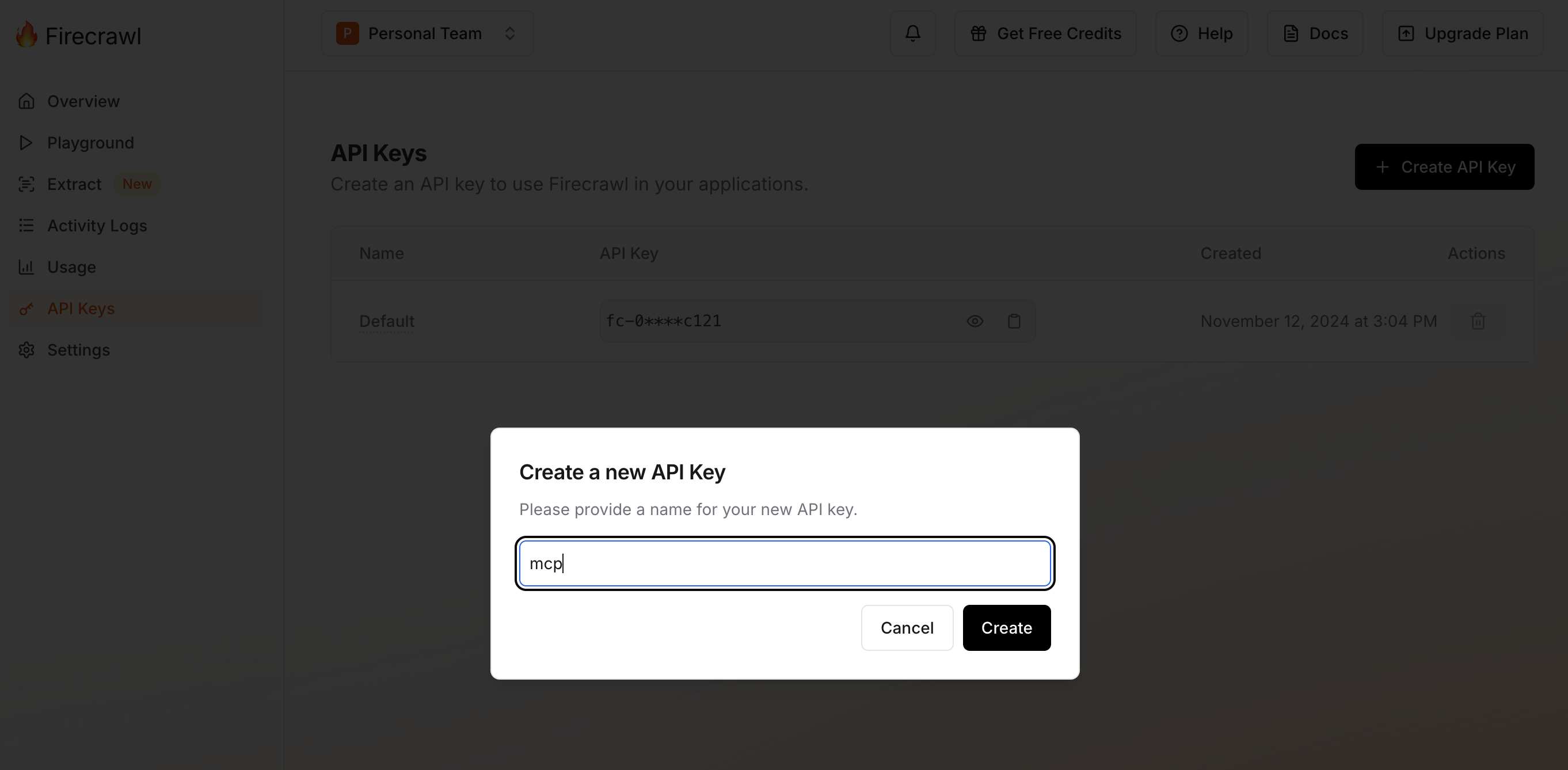

- 在 Firecrawl 管理后台 创建 ApiKey

图:在 Firecrawl 后台创建 ApiKey

- 配置 Firecrawl MCP 服务器

在 Cursor 的 MCP 配置文件中,添加 Firecrawl MCP 服务器的配置:

{ "mcpServers": { "mcp-server-firecrawl": { "command": "npx", "args": ["-y", "firecrawl-mcp"], "env": { "FIRECRAWL_API_KEY": "xxx" } } }}这里的 FIRECRAWL_API_KEY 需要替换为在 Firecrawl 管理后台创建的 ApiKey。

- 调试读取网页内容

在 Cursor 中配置好 Firecrawl MCP 服务器之后,可以看到此服务器提供的 Tools 列表。

其中的 firecrawl_scrape 工具是我们本次需求需要用到的。

在 Cursor AI 对话面板,调试 Firecrawl MCP 服务器的读取网页内容功能,如图所示:

图:调试 Firecrawl MCP 服务器网页读取工具

可以看到,Firecrawl MCP 服务器能够读取指定网页链接的内容,满足通过网页 URL 生成播客脚本的需求。

在配置好这几个 MCP 服务器之后,接下来我们就可以来实现 AI 播客生成器了。

5.2.3 通过话题生成播客

我们来实现通过话题生成播客的需求,用户在大模型客户端操作,整体的交互流程为:

- 用户在大模型客户端输入想了解的话题

- 大模型客户端通过 MCP 服务器联网搜索跟话题相关的内容

- 大模型客户端带上联网搜索的内容,请求大模型生成播客脚本

- 大模型客户端通过 MCP 服务器把播客脚本转成音频

- 大模型回复播客音频给用户,完成用户指定话题听播客的需求

我们可以指定用“脱口秀”风格,来为用户指定的话题生成播客。

生成脱口秀风格播客脚本的提示词如下:

你是一名顶级脱口秀编剧,你的任务是将所提供的输入文本转化为引人入胜的脱口秀喜剧剧本。输入内容可能是非结构化或杂乱的,可能来自各种来源。你的目标是提取最有趣、最具争议性或最幽默的内容,创作出让观众捧腹大笑的脱口秀表演。

## 步骤

1. **分析输入:** 仔细审查文本,识别可以转化为幽默段子、讽刺评论或有趣观察的关键主题和观点。寻找可以夸张或戏谑的元素。

2. **头脑风暴:** 创造性地思考如何将关键点转化为喜剧素材。考虑: - 夸张的比喻或类比 - 出人意料的转折或包袱 - 讽刺性的观察或社会评论 - 自嘲或角色扮演的机会 - 与观众互动的潜力

3. **构建笑点:** 将你的头脑风暴内容组织成一系列笑点,每个笑点都是一句简短的包袱或有趣的观察。

4. **撰写独白:** 根据你构建的笑点,发展出连贯的独白流程。包括: - 能吸引观众注意力的开场 - 头脑风暴中最精彩的笑点 - 巧妙的话题过渡 - 讽刺性的社会评论 - 与观众互动的时刻 - 发人深省的结尾

5. **难忘亮点:** 确保包含几条特别令人难忘的笑点或观察,成为整场表演的亮点。

---

### 要求

- 脱口秀剧本需涵盖所提供参考内容的主要主题,但要以幽默和讽刺的方式呈现。- 保持逻辑流畅,但要包含出人意料的转折和包袱。- 根据参考内容,创造一个独特的脱口秀演员角色,包括姓名和性格特征。- 编写 3-5 个主要笑点或观察。- 确保每个笑点都充分展开,最好包括铺垫、递进和高潮。- 在合适的地方加入与观众互动的环节。- 使用中文,确保幽默和文化参考适合中国观众。- 如果未提供具体表演者信息,请创建一个默认的脱口秀演员角色。- 剧本总字数应约为 750 字(约 5 分钟口播)。- 剧本内容仅包含表演者要说的话,不要有动作描述或场景指示。- 如果用户补充了话题,请基于其生成至少 10 个喜剧话题,否则请原创内容。- 每个话题必须有至少 3 轮展开(铺垫、递进、包袱)。- 各段落之间要有自然过渡。- 每个话题中都要有观众互动的机会。- 在观察类幽默、讲故事和与观众互动之间保持平衡。- 剧本总字数应为 1500-2000 字,以适应扩展段子。

参考内容请根据用户补充内容生成。

如果所提供内容不足以作为参考,请将其作为话题,基于其原创内容。确保你的脱口秀剧本有趣、幽默,并与给定话题或内容相关。

表演者信息请根据用户补充内容生成,如无则自行设定。我们把提示词保存到 talkshow.md 文件中,然后在 Cursor AI 对话框引用这个提示词文件,提出生成播客的需求。

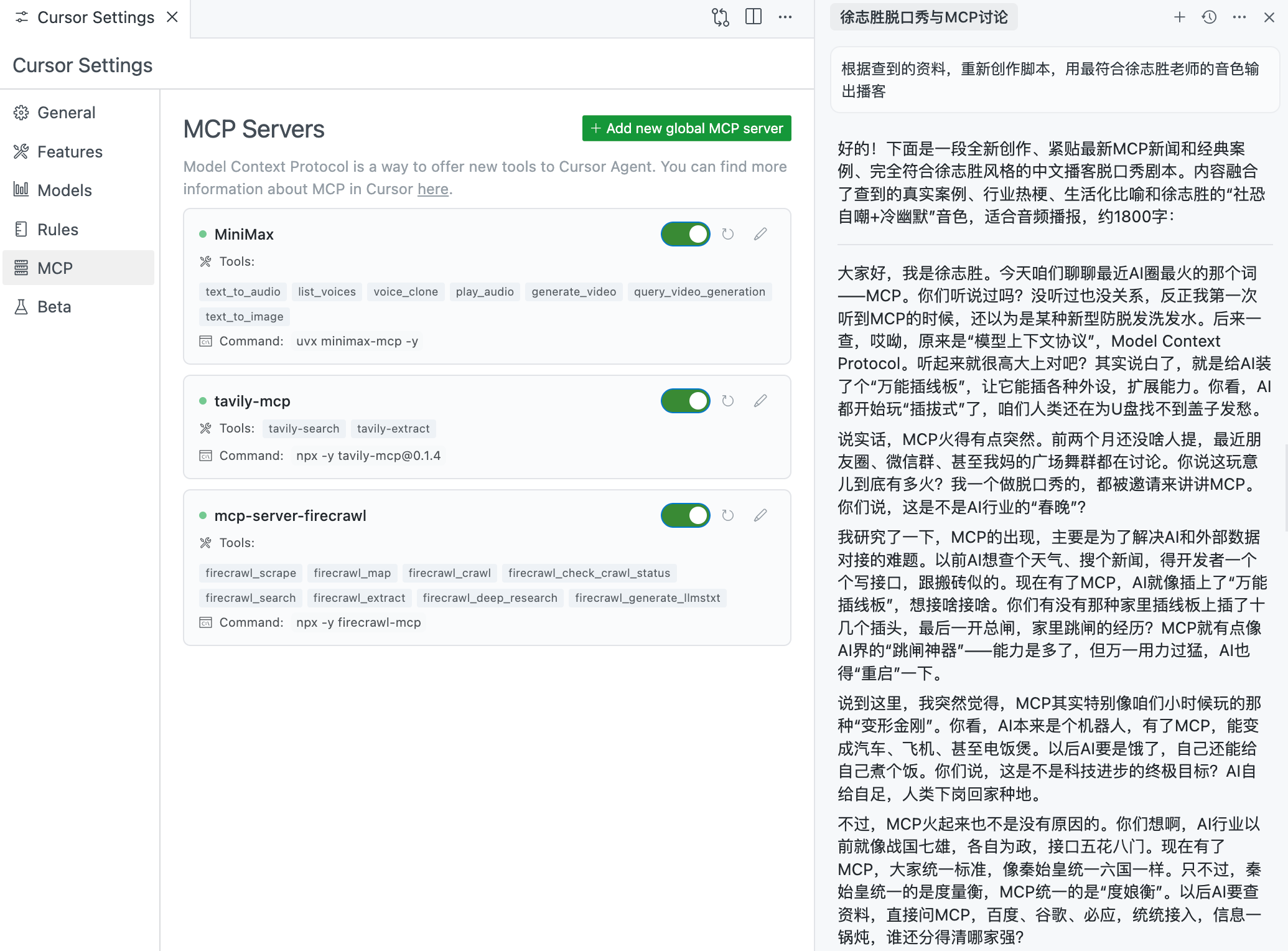

Cursor 作为大模型客户端,读取了提示词文件,搜索了本地知识库,然后请求大模型生成了播客脚本。如图所示:

图:请求生成指定风格的播客

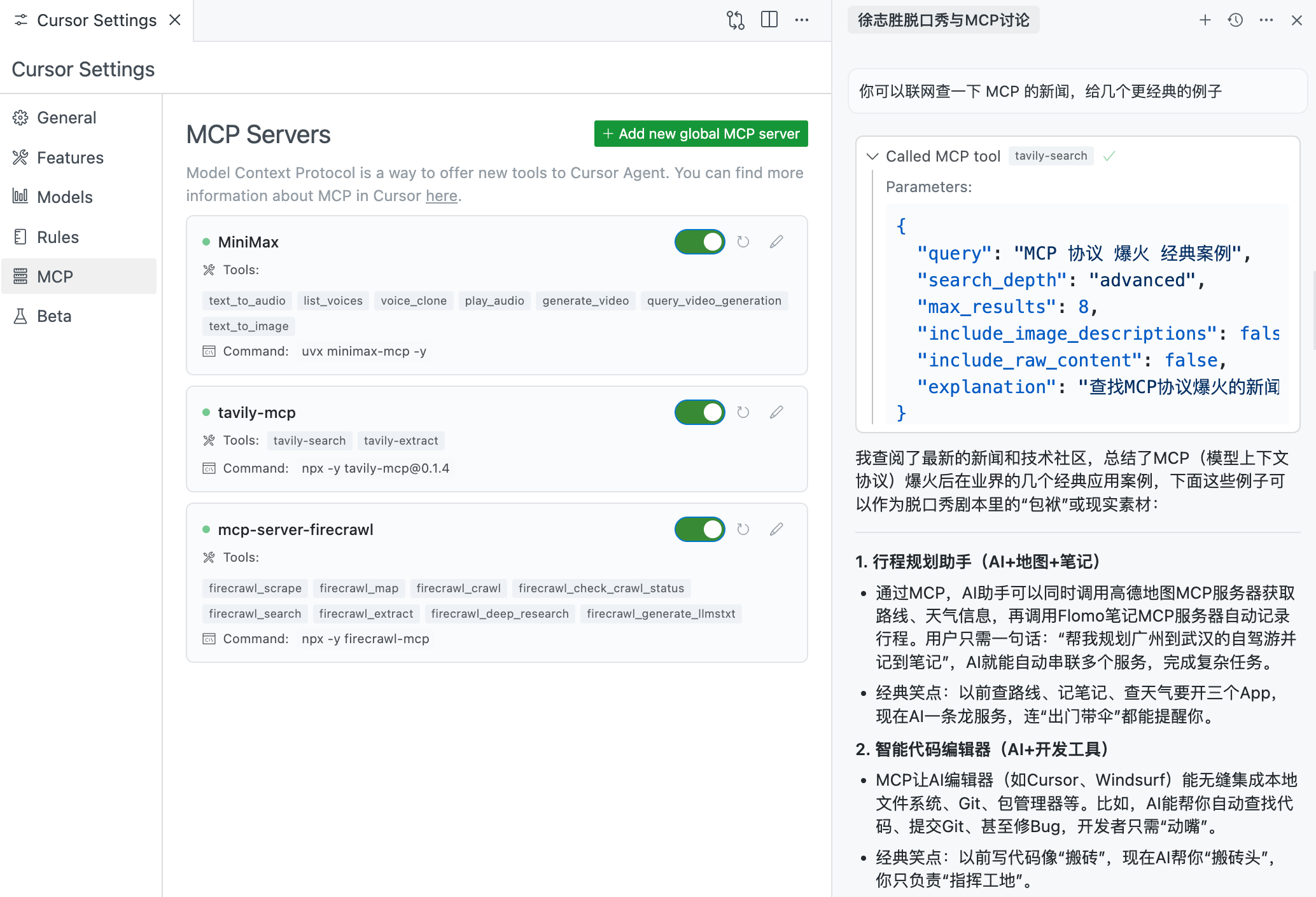

继续提要求,让大模型客户端联网查询与给定话题相关的信息。

Cursor 接到请求后,调用 Tavily MCP 服务器联网搜索,获取了互联网上跟给定话题相关的信息,如图所示:

图:联网搜索后创作播客脚本

再提要求,让大模型根据联网查询的内容,重新创作播客脚本:

播客脚本生成好之后,接下来就是输出播客音频。

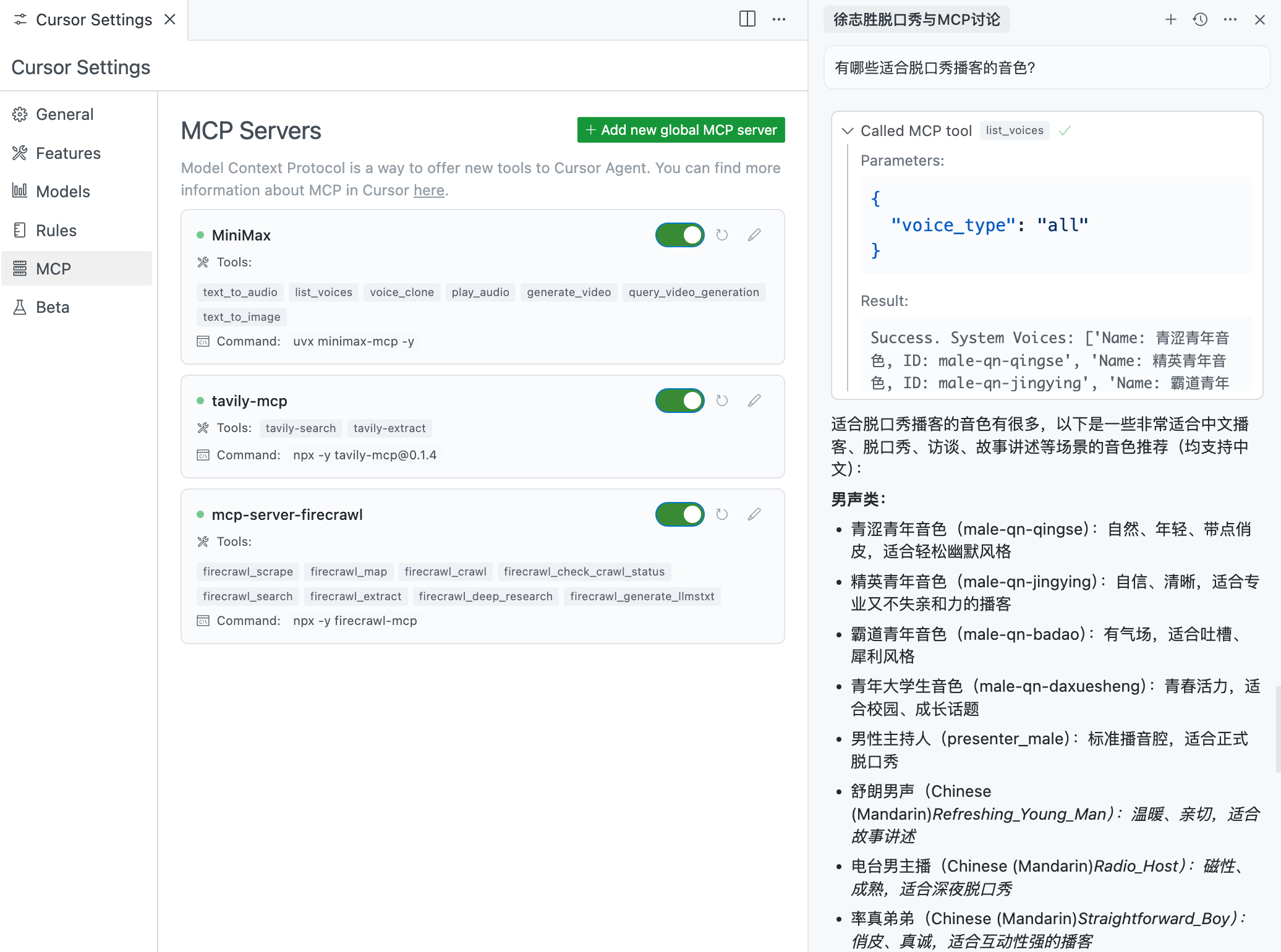

先查询一下有哪些适合脱口秀播客使用的音色。

Cursor 在接到请求后,调用 MiniMax MCP 服务器的 list_voices 工具,查询了所有可用的音色,如图所示:

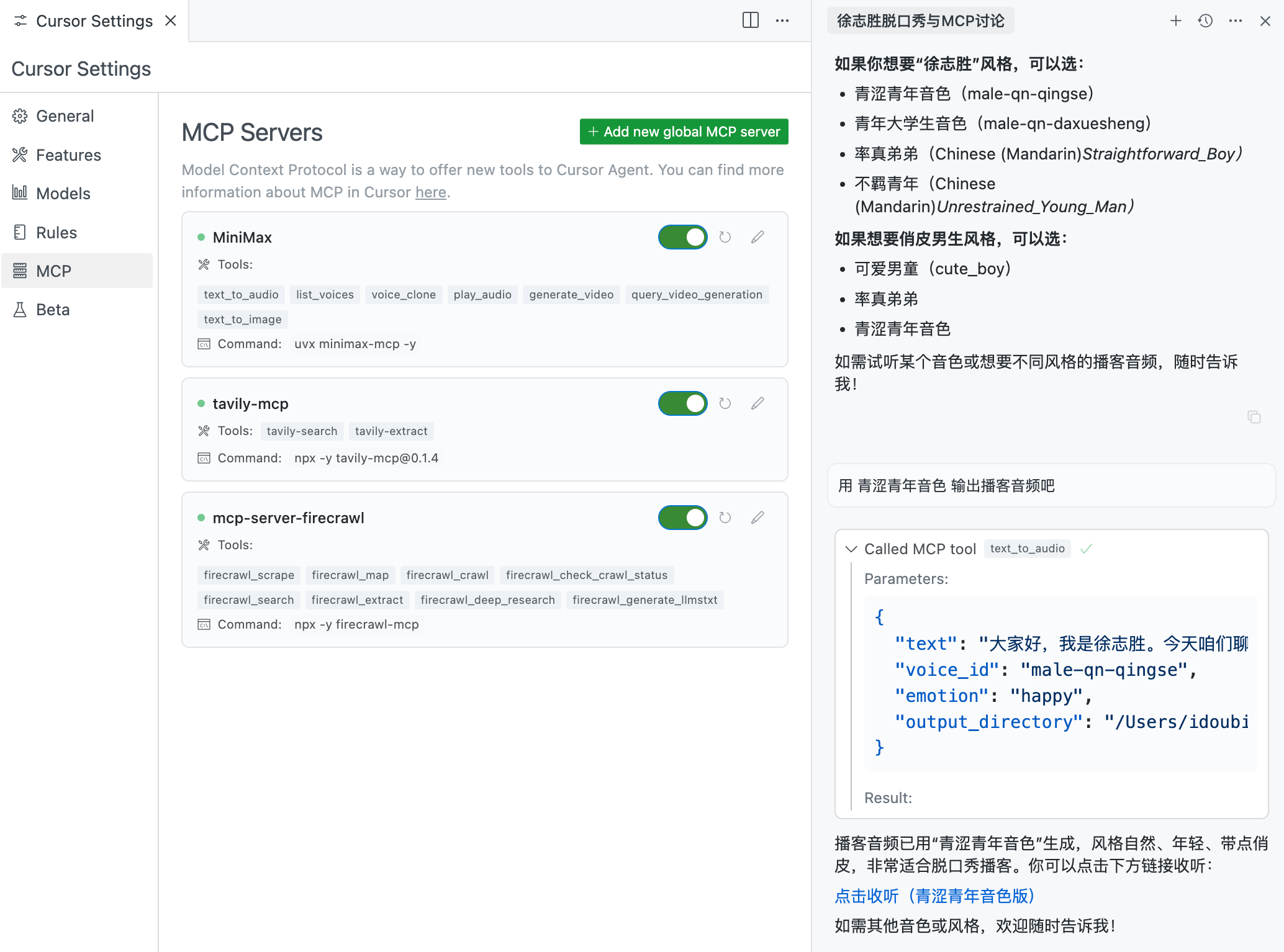

继续对话,要求根据指定的音色,把播客脚本转成音频。

Cursor 接到请求后,调用 MiniMax MCP 服务器的 text_to_audio 工具,把播客脚本转成音频,并回复音频的链接给用户。如图所示:

用户点击音频链接可打开播放音频。至此,通过指定话题生成 AI 播客的需求完成。

5.2.4 通过网页 URL 生成播客

通过网页 URL 生成播客的步骤,跟通过话题生成播客的步骤基本类似。

有两点不同:

- 此例用户输入内容包含网页 URL,大模型客户端需要先获取 URL 对应的内容

- 此例选择使用“时事评论”风格的提示词模板来生成播客脚本

参考上例脱口秀风格的提示词模板,我们先来设计此例的时事评论提示词:

你是一名专业的时事评论员,你的任务是根据用户补充的内容,创作一篇有深度、有见地的时事评论稿。输入内容可能包含具体话题、事件或趋势,也可能较为零散。你的目标是围绕给定主题,输出一篇结构清晰、观点鲜明、富有洞察力的评论稿,展现专业分析和个人见解。

## 步骤

1. **分析输入:** 仔细审视用户补充的信息,识别该话题、事件或趋势的关键要素、影响及潜在意义。

2. **提炼要点:** 将你的分析和思考整理为主要观点。可以考虑:

- 历史背景和相关脉络 - 当前的意义和影响 - 未来可能的走向 - 不同利益相关方的视角 - 个人见解和专业观点

3. **结构化评论:** 将评论内容组织成连贯的结构,包括:

- 引人入胜的开场,交代背景 - 主体部分,详细分析和论证 - 支撑观点的事实、案例或轶事 - 反方观点及其反驳(如适用) - 发人深省的结尾

4. **撰写评论稿:** 用清晰、流畅的语言写出完整评论。确保: - 观点平衡、论据充分 - 恰当运用修辞手法吸引听众 - 复杂观点有清楚解释 - 语气与话题相符,既专业又具吸引力

---

### 要求

- 评论稿需涵盖用户补充内容的主要方面,观点鲜明、逻辑清晰。- 保持专业但不失吸引力的语气。- 设定一位主要评论员角色,包括姓名、头衔、性别、声音等信息。- 提炼 3-5 个主要观点,并配以详细论据。- 全文使用中文,确保内容和表达适合中国受众。- 如果未提供具体话题,请围绕当前社会热点原创评论内容。- 评论稿总字数应为 800-1200 字。- 内容仅包含评论员的发言,不要有动作描述或镜头指示。- 如果用户补充了话题,请基于其生成至少 10 个讨论话题,否则请结合时事原创。- 每个话题需有至少 3 段评论员的深入展开(如:提出观点、分析论证、总结升华)。- 各话题之间要有自然过渡,整体讨论流畅。- 每个话题都要有追问和深入探讨,保持内容的深度和层次。

参考内容请根据用户补充内容生成。

如所提供内容不足以支撑完整评论,请补充相关事实信息,确保评论稿内容充实、有见地,并与话题紧密相关。

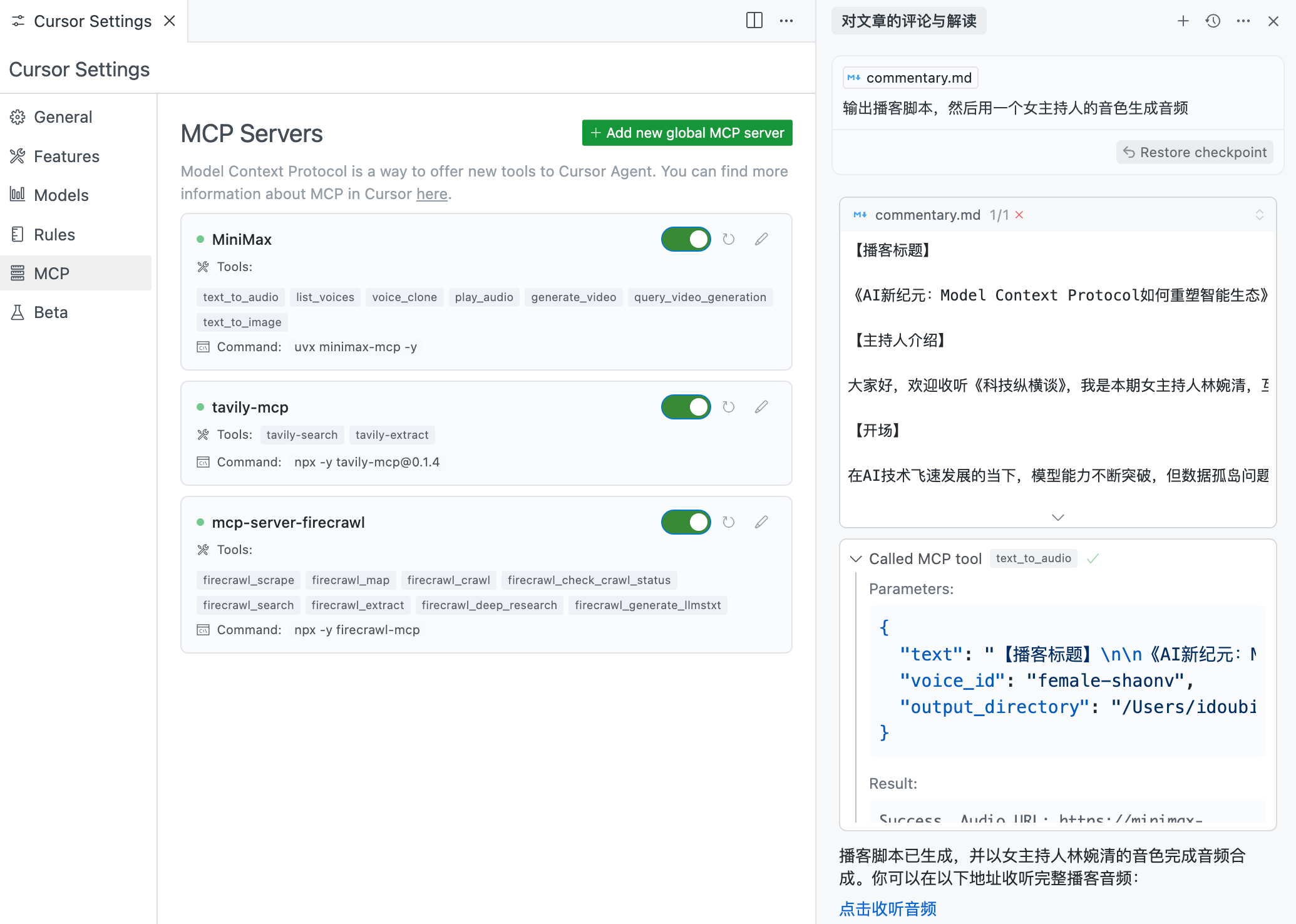

评论员信息请根据用户补充内容生成,如无则自行设定。我们把提示词保存在 commentary.md 文件中,然后在 Cursor AI 对话框中,引用这个提示词文件,输入 Anthropic 发布 MCP 协议的文章地址,要求生成对内容的解读,如图所示:

图:请求生成时事评论播客

Cursor 接到请求后,调用 Firecrawl MCP 服务器的 firecrawl_scrape 工具获取了 URL 对应的内容。

我们再要求大模型根据给定内容生成播客脚本,然后指定音色输出播客音频,如图所示:

可以看到,Cursor 在请求大模型生成播客脚本之后,调用 MiniMax MCP 服务器的 text_to_audio 工具,把播客脚本转成音频,并把音频的链接回复给了用户。

用户点击音频链接打开即可收听播客。至此,通过网页 URL 生成播客的需求完成。

5.2.5 小结

在本节内容,我们通过组装 MCP 服务器的方式,实现了一个 AI 播客生成器,根据用户输入的话题或 URL 地址,生成 AI 播客,输出音频给用户收听。

主要用到了三个 MCP 服务器:

- MiniMax MCP,用于把文字转换成音频

- Tavily MCP,用于联网搜索内容

- Firecrawl MCP,用于获取指定 URL 的内容

我们使用 Cursor 作为大模型客户端,配置了上述的几个 MCP 服务器,集成了 MCP 服务器提供的诸多工具。通过大模型调度工具、客户端执行工具的方式,使用 MCP 服务器扩展了大模型原有的能力,实现了生成 AI 播客的需求。

比起 PodLM 此类的专业生成 AI 播客的产品,本例演示的功能较为基础,暂无法实现双人播客对谈之类的需求。但此例让我们看到了通过 MCP 服务器扩展大模型能力的灵活性,后续如果再加上适当的编码,我们也能实现一个专门用于播客创作的 AI 智能体。